摘要:隨著大模型,尤其是開源大模型的持續(xù)進化,具備復雜推理能力的模型正在逐步應用于各行各業(yè),并展現(xiàn)出超越人類專家的潛力。

隨著大模型,尤其是開源大模型的持續(xù)進化,具備復雜推理能力的模型正在逐步應用于各行各業(yè),并展現(xiàn)出超越人類專家的潛力。得益于此,未來的算力建設將更加聚焦于推理場景,而不僅僅是訓練算力。

華福證券的研究指出,到2027年,推理端的人工智能服務器預計將占整體工作負載的72.6%。同時,OpenAI o1 所代表的大模型推理場景的 Scaling Law 也進一步助推了這一趨勢的加速發(fā)展。

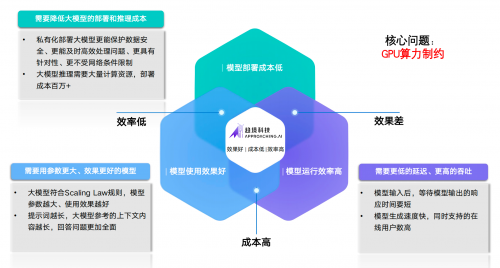

然而,盡管模型的效果有了顯著的提升,數(shù)百億參數(shù)、上百萬上下文的一線模型在實際部署中仍面臨高成本和低效率的挑戰(zhàn)。這一現(xiàn)象導致了難以破解的“不可能三角”。

為了應對這一困境,亟需新型推理架構(gòu),打破傳統(tǒng)主要為訓練場景設計,以高端 GPU 為中心的算力架構(gòu)設計思路。

在此背景下,趨境科技推出了“大模型知識推理一體機”,其搭載的業(yè)界首創(chuàng)的全系統(tǒng)推理架構(gòu)能夠通過協(xié)同存儲、CPU、GPU、NPU等多種設備,充分釋放異構(gòu)算力,將推理成本降低10倍以上。

這一創(chuàng)新為企業(yè)實現(xiàn)大模型的高效落地提供了全新選擇,開啟了通向“推理自由”的新途徑。

趨境大模型知識推理一體機不僅支持本地部署數(shù)百億級別的一線大模型,還提供開放的API接口,便于第三方靈活調(diào)用。同時,用戶可根據(jù)需求定制企業(yè)智能助手(assistant/copilot),實現(xiàn)真正的“開箱即用”。

協(xié)同 HBM/DRAM/SSD 和 CPU/GPU/NPU 全系統(tǒng)異構(gòu)設備,充分釋放異構(gòu)存力和算力資源

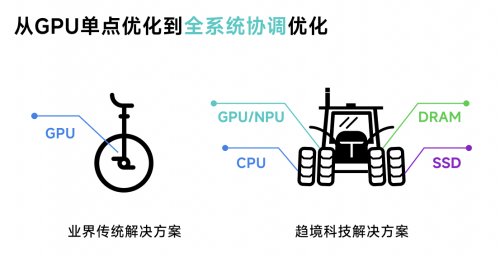

與當前行業(yè)主要針對 GPU 算力利用率進行單點優(yōu)化的傳統(tǒng)方案相比,趨境科技大模型知識推理一體機采用了業(yè)界首創(chuàng)的全系統(tǒng)推理架構(gòu)。

其通過“以存換算”技術(shù)釋放存力作為算力的補充,降低對算力的需求;同時采用“異構(gòu)協(xié)同”的思路,緊密聯(lián)動 HBM/DRAM/SSD 和 CPU/GPU/NPU 全系統(tǒng)異構(gòu)設備,突破顯存容量的限制,充分釋放全系統(tǒng)的存力和算力。

這一創(chuàng)新方案突破了以往方案的理論優(yōu)化極限,實現(xiàn)了整合機器所有異構(gòu)算力資源的目標,使得推理吞吐量提升超過10倍,大幅降低了大模型的落地成本。

此外,據(jù)財通證券發(fā)布的行業(yè)深度分析報告統(tǒng)計顯示,國產(chǎn)GPU產(chǎn)品在單精度/半精度浮點算力、制程及顯存容量上都與英偉達有2-4倍的顯著差距。因此,僅依靠GPU單點優(yōu)化,短時間內(nèi)很難趕超英偉達GPU方案。

而采用全系統(tǒng)推理架構(gòu)可以大幅降低GPU性能差距的影響,顯著提升國產(chǎn)替代解決方案的競爭力,打破在大模型推理場景下國產(chǎn)GPU“卡脖子”的困境。

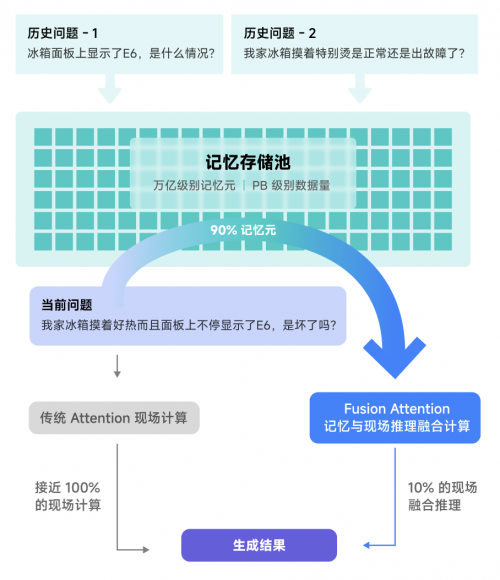

以存換算新范式,從“死記硬背”到“融合推理”

早期的大模型推理架構(gòu)將每次推理視為獨立請求,缺乏高效處理所需的“記憶”能力。盡管后續(xù)引入了近似問題緩存(Semantic Query Cache)和前綴緩存(Prefix KVCache Cache),但仍主要依賴于“死記硬背”。這些方案要求新問題與已處理問題高度一致才能利用緩存去降低算力需求。

針對這一問題,趨境科技創(chuàng)新性地設計了“融合推理(Fusion Attention)”技術(shù),即便是面對全新的問題也可以從歷史相關(guān)信息中提取可復用的部分內(nèi)容,與現(xiàn)場信息進行在線融合計算。這一技術(shù)顯著提升了可復用的歷史計算結(jié)果,進而降低了計算量。

通過這一新思路,趨境大模型知識推理一體機充分利用了存儲資源。采用“以存換算”的方式釋放存力作為對于算力的補充,在RAG場景中,響應延遲降低20倍,性能提升達10倍。

全系統(tǒng)異構(gòu)協(xié)同新架構(gòu),從GPU單點優(yōu)化到全系統(tǒng)協(xié)同優(yōu)化

除了通過“以存換算”降低算力需求外,趨境大模型知識推理一體機還進一步通過全系統(tǒng)異構(gòu)協(xié)同架構(gòu)設計,將來自存儲、CPU、GPU、NPU的算力高效融合,進一步提升大模型推理性能,降低成本。

此前,趨境科技與清華 KVCache.AI 團隊合作,開源了一部分異構(gòu)推理框架,項目名為“KTransformers”(GitHub鏈接:https://github.com/kvcache-ai/ktransformers),該開源框架僅需單個消費級 GPU 即可在本地運行 Mixtral 8x22B 和DeepSeek-Coder-V2 等千億級大模型,性能數(shù)倍于 Llama.cpp。

在長達 1M 的超長上下文推理任務中,成為業(yè)界首個僅需單 GPU 卡的高性能推理框架,生成速度達到 16.91 token/s,比 Llama.cpp 快10倍以上,同時維持接近滿分的“大海撈針”能力。

趨境科技大模型知識推理一體機采用的全系統(tǒng)推理架構(gòu)是基于“KTransformers”進一步完善的商業(yè)版本,在開源版的基礎上,協(xié)同性能更強,加入了多卡高并發(fā)調(diào)度、RAG支持等策略。經(jīng)過測試及客戶合作驗證,Prefill 和 Generate 性能大幅領(lǐng)先業(yè)界方案:

Prefill階段的 TTFT(響應延遲)相比業(yè)界方案快6倍以上

Generate階段的 TPOT(生成速度)相比業(yè)界方案快3.48倍以上

趨境x長亭:為安全大模型開啟千億大模型時代

國內(nèi)頂尖的網(wǎng)絡信息安全公司長亭科技,使用趨境科技提供的全系統(tǒng)異構(gòu)推理架構(gòu)技術(shù)策略,無縫銜接到其原有的“問津(ChaitinAI)安全大模型”、MSS 安全托管服務等產(chǎn)品中,問津(ChaitinAI)安全大模型升級為千億大模型,安全性能全方位升級:

核心指標攻擊識別準確率提升至95.8%,檢測時延降低至秒級。另外,其對漏洞的檢測能力增強,不僅提升漏洞發(fā)現(xiàn)數(shù)量,對應的修復建議也更準確,還能基于不同場景選擇更合適的工具和策略。同時,對不良內(nèi)容識別能力升級,準確率和召回率均有提升。安全報告內(nèi)容生成質(zhì)量和評分也顯著提高,綜合輸出更具健壯性和穩(wěn)定性。

此外,長亭科技的安全大模型的部署資源成本降低50%,助推其更多業(yè)務加入大模型能力。

技術(shù)的不斷進步和市場需求為大模型的未來發(fā)展提供了廣闊的空間。隨著算力基礎設施的不斷完善,提升算力的利用效率,使大模型能與更多的行業(yè)實踐結(jié)合起來,未來大模型將在更多行業(yè)中發(fā)揮更大的作用。

趨境目前也正在和更多的大模型應用廠商一同協(xié)作,希望助推全面智能化的到來。

2025我國AI核心產(chǎn)業(yè)將破萬億,現(xiàn)存相關(guān)企業(yè)超491萬家

6天前

6天前本次論壇的成功舉辦,正是張江機器人谷全鏈條產(chǎn)業(yè)生態(tài)與創(chuàng)新生態(tài)的集中體現(xiàn)。

2025-12-14

2025-12-1412月11日,華為正式公布兩項鴻蒙電腦新進展——華為擎云 HM740以及鴻蒙電腦專業(yè)版操作系統(tǒng)發(fā)布。

2025-12-11

2025-12-11iRobot深陷危機或易主中國,國內(nèi)現(xiàn)存機器人相關(guān)企業(yè)超102.2萬家

2025-12-10

2025-12-10當戶外探索遇上智能科技,行業(yè)邊界正被持續(xù)打破。2025年12月,探路者第二代下肢外骨骼在北京多家門店...

2025-12-05

2025-12-0512月2日,由廣西北部灣國際港務集團有限公司(簡稱“北部灣港集團”)與廣西上市公司協(xié)會聯(lián)合主辦的“向...

2025-12-05

2025-12-05全球通脹高企與經(jīng)濟波動加劇的2025年,黃金憑借其避險屬性與24小時交易機制,成為越來越多投資者資產(chǎn)...

2025-12-05

2025-12-05在國內(nèi)知名科技產(chǎn)業(yè)智庫甲子光年主辦的「2025 甲子引力年終盛典」上,浩鯨科技憑借 AI Agent...

2025-12-05

2025-12-05當一部分企業(yè)還在討論AI能做什么時,領(lǐng)先的大廠已經(jīng)悄悄完成了一場組織變革:HR、法務、營銷、財務等部...

2025-12-05

2025-12-05投資家網(wǎng)(www.hbzbj.cn)是國內(nèi)領(lǐng)先的資本與產(chǎn)業(yè)創(chuàng)新綜合服務平臺。為活躍于中國市場的VC/PE、上市公司、創(chuàng)業(yè)企業(yè)、地方政府等提供專業(yè)的第三方信息服務,包括行業(yè)媒體、智庫服務、會議服務及生態(tài)服務。長按右側(cè)二維碼添加"投資哥"可與小編深入交流,并可加入微信群參與官方活動,趕快行動吧。